DEEL : la recherche fondamentale pour certifier l’IA

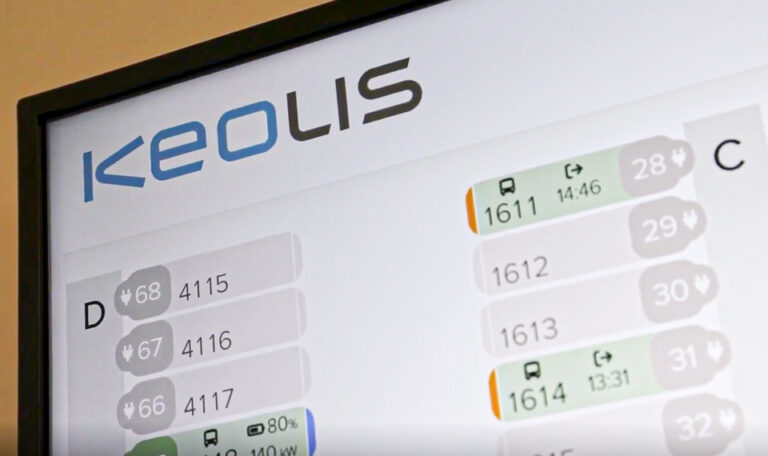

L’intelligence artificielle se répand de plus en plus dans nos usages numériques au quotidien, des filtres photos amusants aux deep fakes drôles ou inquiétants. Mais pouvons-nous lui faire confiance pour conduire un train ? Et si oui, dans quelles circonstances, et à quel point ? Le projet DEEL tente de répondre à ces questions en délimitant le champ d’application de l’IA et en chiffrant précisément son efficacité, avec en fond une question fondamentale : comment fonctionne l’intelligence artificielle ?

Publié le

Par La Redaction

Pour le grand public, le fait qu’une intelligence artificielle se trompe ne représente que rarement un danger véritable, mais quand il s’agit de confier des vies humaines à un programme, la question de certifier l’efficacité de l’IA est posée. La voiture dont vous prenez le volant doit répondre à des critères bien précis de sécurité, et chaque constructeur sait précisément le taux de panne de chacune des pièces qui la composent. Il en va de même pour les trains aujourd’hui, mais qu’en sera-t-il lorsque l’on déléguera une partie des tâches de conduite à un logiciel ?

© Laurent Mayeux

La plupart des programmes d’IA fonctionnent comme des boîtes noires : les développeurs fournissent des données pour enseigner une fonction précise, et vérifient ensuite que l’intelligence artificielle produit des résultats cohérents. Mais comme les algorithmes modifient certains paramètres (le poids des stimuli virtuels reçus par les neurones artificiels) pendant leur apprentissage, on ne sait pas comment fonctionne exactement la partie machine learning du programme. Impossible alors de quantifier son efficacité : une IA qui doit lire l’état d’un feu de signalisation peut parfaitement fonctionner avec les données qu’on lui a fourni, mais flancher si un banc de brouillard passe devant la signalétique. C’est un peu comme si on cherchait à enseigner la multiplication à un enfant en lui montrant des milliers d’exemples. On peut contrôler s’il a bien compris avec des exercices, mais on ne saura pas avec certitude qu’il a bien assimilé les règles qui régissent la multiplication.

Ce manque de visibilité sur la mécanique interne de l’algorithme de machine learning entraîne un manque de confiance envers sa robustesse. Comment être sûr que l’IA utilise un raisonnement qui sera applicable à toutes les situations ? Ou du moins quantifier avec précision la probabilité qu’elle se trompe dans telle ou telle situation ? C’est là tout l’intérêt d’une démarche comme celle de DEEL : faire disparaître ces inconnues pour instaurer une IA de confiance sur laquelle il serait possible de faire reposer des vies humaines.

© Laurent Mayeux

Savoir expliquer l’IA

© Laurent Mayeux

C’est là qu’intervient le projet DEEL, pour Dependable and Explainable Learning, soit Apprentissage fiable et explicable. L’initiative franco-canadienne réunit trois groupes : la Core Team, composée de chercheurs en mathématiques et en intelligence artificielle, l’équipe des industriels, et l’équipe des ingénieurs, les trois communiquant régulièrement entre elles. Cela représente une cinquantaine de personnes, issues d’entreprises comme Airbus, Thalès, Continental ou Bombardier, qui se réunissent tous les mois notamment pour effectuer une « acculturation croisée » selon Laurent Gardes, responsable de la division IA à la Direction Technologies, Innovation & Projets Groupe de SNCF. Au cœur du projet, l’explicabilité – pouvoir détailler la façon dont fonctionne un algorithme de machine learning – ainsi que plusieurs autres piliers pour pouvoir délimiter et évaluer les intelligences artificielles : la robustesse, la détection d’anomalies, l’équité de traitement, la vérifiabilité, la spécificité, l’évaluation probabiliste, la résilience, la qualité des données…

© Laurent Mayeux

Le défi de la certification

« On ne peut pas garantir formellement le fonctionnement de l’IA, mais on veut pouvoir délimiter son champ d’application », explique Laurent Gardes. Le but est de pouvoir dire, pour un algorithme donné, qu’il fonctionne de manière optimale dans certaines conditions (par exemple avec 99,99% de réussite avec une météo normale), et savoir quand il cesse de fonctionner (par exemple si la reconnaissance de feux de signalisation baisse à 75% lors d’un orage).

Dans le cadre du train autonome, cette certification remplira plusieurs objectifs : rassurer les voyageurs, permettre aux assureurs de couvrir la SNCF, et éviter les accidents en permettant à un conducteur humain de reprendre la main quand les conditions optimales pour le fonctionnement de l’IA ne sont pas remplies.

Mais le défi s’annonce de taille. « Aujourd’hui la marge d’erreur est d’environ 1%, on voudrait pouvoir arriver à 1 fois sur 1 million » estime Laurent Gardes, convaincu que la mission actuelle de DEEL, qui a démarré en 2019 et doit s’achever en 2024, ne fera que parcourir une partie du chemin vers la certification de l’IA. C’est un réel travail de fond, ayant des liens profonds avec la recherche fondamentale en mathématique et en informatique.

Un effort de longue haleine

© Laurent Mayeux

Un second projet connexe à DEEL, Confiance IA, a d’ailleurs démarré en 2020 sur la même thématique, qui intéresse presque tous les grands noms du transport, des avionneurs aux fabricants automobiles, ainsi que d’autres industriels tel qu’Air Liquide. Ce nouveau projet doit faire entrer les résultats de DEEL dans la phase d’industrialisation. Même au sein de la SNCF, l’idée d’une IA dont on peut mesurer et comprendre le fonctionnement rayonne bien au-delà de l’équipe Train autonome, avec par exemple l’utilisation des robots conversationnels par les équipes de vente, ou les efforts pour simplifier et renforcer la vidéo-surveillance à l’aide de l’intelligence artificielle.

La SNCF s’est engagée à travers DEEL dans la résolution d’une vraie question de société, qui vise à permettre l’intégration d’une IA sûre dans notre vie quotidienne, afin de pouvoir bénéficier de programmes informatiques intelligents et fiables, avec la confiance de toutes et tous.

© Laurent Mayeux

Crédit : Laurent Mayeux