Le Deep learning, la clé de l’IA ?

Hier, le prix Turing a été décerné à trois chercheurs dont le français Yann LeCun, pour leurs travaux sur le « deep learning », élément clef du développement d’une IA performante. La conférence « L’Intelligence artificielle s’invite chez SNCF », organisée par e-SNCF en mars dernier abordait l’ensemble des enjeux liés à l’intelligence artificielle.

Publié le

Par La Redaction

Et l’IA est déjà là : des coulisses des hôpitaux (où elle permet de lire une radio avec plus de précision que ses confrères humains), aux services juridiques (où elle parcourt la jurisprudence plus rapidement qu’un avocat), en passant sur l’appui des plus grandes plateformes (Google, Amazon…). Si l’IA a déjà connu des périodes de rebonds et d’abandons, elle évolue rapidement. Pour preuve, l’annonce d’Elon Musk de miser sur des implants cérébraux, dispositifs reliant directement notre cerveau aux objets connectés : bienvenue dans les prémices de l’homme « augmenté » !

Comment expliquer ce regain de vigueur ? C’est à cette question que les experts présents à la conférence « L’Intelligence artificielle s’invite chez SNCF » ont tenté d’apporter des réponses.

Le retour de l’IA ?

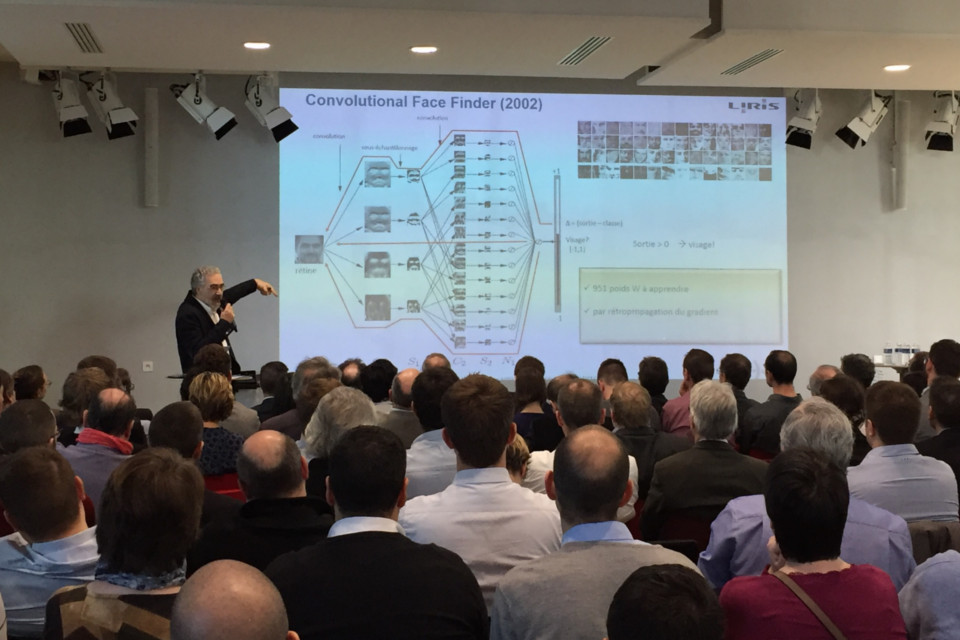

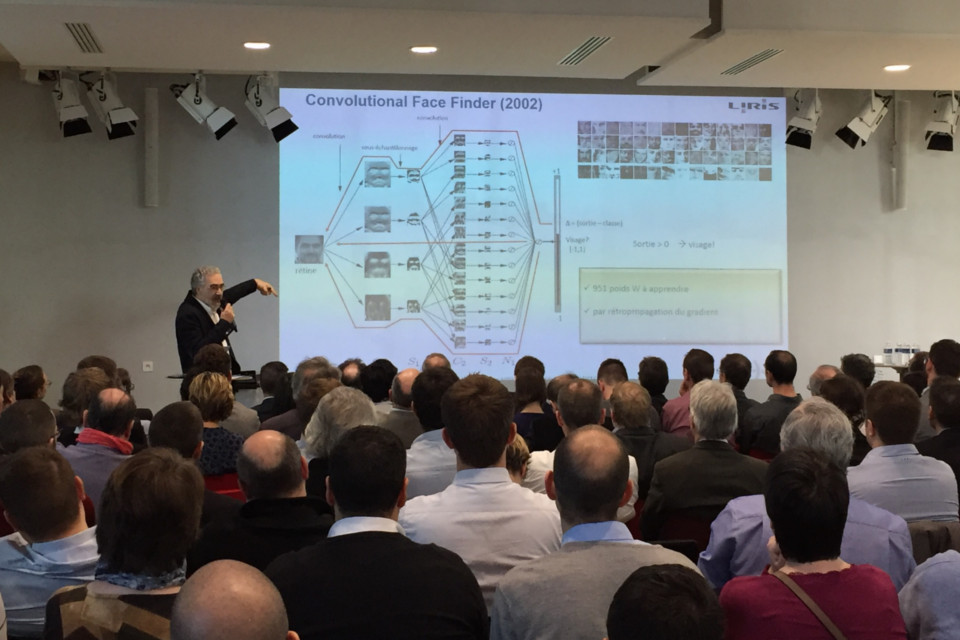

« Deep Learning » : voici le maître-mot du colloque. Cette technique d’enrichissement de l’IA (une méthode d’apprentissage automatique à partir des données) prend racines dans l’architecture du cerveau humain. C’est d’ailleurs ce que rappelle Christophe Garcia, premier conférencier et spécialiste au sein du Laboratoire d’informatique en image et systèmes d’information.

Pendant les années 40, des neuroscientifiques comme Warren McCulloch ou Walter Pitts ont mené des études sur le fonctionnement de notre encéphale, et en ont établi un schéma structurant toujours utilisé : le cerveau humain est constitué de neurones reliés les uns aux autres par des synapses. Ces dernières transmettent des informations venant de l’extérieur, faisant réagir nos neurones.

À la fin de la décennie suivante, Frank Rosenblatt a créé un cerveau artificiel pour traduire ces notions encore abstraites. Celui-ci est alors intégré dans une machine nommée « perceptron ». À travers cette vidéo, Christophe Garcia démontre au public que, suivant un processus d’apprentissage, le perceptron est en effet capable de reconnaître des images et, par la suite, de classifier une photo totalement nouvelle. Après une dizaine d’années sans véritable avancée, « l’IA est de retour » estime Christophe Garcia. Dans un contexte marqué par une grande puissance de calcul et une importante masse de données produites, elle acquiert un nouveau fonctionnement d’apprentissage par « couches ». Des milliers de neurones, dont chacun peut effectuer des calculs simples, forment des dizaines voire des centaines de couches, et les résultats des premières couches vont servir d’entrée aux calculs des prochaines. L’IA peut désormais apprendre de manière « profonde ».

Repositionner son projet digital

L’IA spécialisée (ou IA « faible ») est conçue pour réaliser des tâches complexes mais spécifiques. De fait, malgré la profondeur de ses connaissances, l’IA faible ne peut rivaliser avec la transversalité du cerveau humain. Alors qu’elle peut être multitâche, l’humain est multi-compétences, une différence qui change tout. L’utilisation industrielle de l’IA faible ne pourra donc négliger l’implication de l’homme.

Ainsi, lors de son intervention, Gérard Yahiaoui explique l’importance de positionner ses projets industriels en collaboration avec des experts métiers. Au travers de programmes impliquant la création des réseaux neuronaux, le PDG de Nexyad propose une méthodologie à suivre, afin de booster au maximum la productivité des industriels grâce à l’IA.

Selon lui, la performance des systèmes neuronaux artificiels dépend notamment de celle du « poids synaptique » intégré, et de la quantité de données à disposition. Pour rendre efficace le processus d’apprentissage, les poids synaptiques doivent être modulés en fonction des variables existant sur les résultats d’analyse, comme le nombre de pixels dans une image, la température, etc. Il est donc nécessaire d’identifier tous ces facteurs en amont du projet, pour appliquer ensuite des outils de filtrage spécifiques. L’objectif est ainsi de créer un environnement d’exploitation optimisé. « Les experts métiers jouent un rôle important », souligne-t-il, car ils disposent d’une parfaite connaissance des données industrielles. Par ailleurs, le fait de les placer au cœur du processus d’identification des mesures à relever permet, à terme, de disposer de protocoles clairs, compréhensibles par tous ; cela contribue ainsi à l’enrichissement des règles métiers.

Le projet CAFEINE de SNCF est justement mené de cette façon. Les caméras utilisées dans ce cadre sont capables de filmer, de haut, les trains en circulation. Elles pourront détecter des signaux faibles des éventuels arrachages de caténaires, ou contribuer à mieux suivre l’évolution de pantographes … En route pour la maintenance prédictive assistée par l’Intelligence Artificielle !